English Version Below

Trong cuộc chiến chống tội phạm mạng , AI vừa là mối đe dọa đang gia tăng vừa là đồng minh mới tiềm năng.

Trong khi các mô hình ngôn ngữ lớn (LLM) có thể làm mờ ranh giới giữa người dùng xác thực và kẻ mạo danh, chúng cũng có thể giúp CSO tìm ra lỗ hổng ẩn và dự đoán nơi có thể xảy ra cuộc tấn công tiếp theo.

Chúng tôi xem xét tính chất hai mặt của AI và xem LLM đang được sử dụng cho cả mục đích xấu và tốt như thế nào.

Những điểm chínhĐối với các chuyên gia bảo mật. Tác động của AI có cả mặt tiêu cực và tích cực .

Tin tặc đang sử dụng GenAI để tăng cường khả năng khai thác và điều chỉnh kỹ thuật của mình.

Tuy nhiên, LLM cũng cung cấp cho các nhóm trung tâm điều hành bảo mật (SOC) những khả năng mới để ứng phó sự cố và quản lý lỗ hổng.

Hai mặt của AI đang buộc phải suy nghĩ lại về mạng như thế nào

Trong cuộc chiến chống tội phạm mạng , AI vừa là mối đe dọa đang gia tăng vừa là đồng minh mới tiềm năng.

Trong khi các mô hình ngôn ngữ lớn (LLM) có thể làm mờ ranh giới giữa người dùng xác thực và kẻ mạo danh, chúng cũng có thể giúp CSO tìm ra lỗ hổng ẩn và dự đoán nơi có thể xảy ra cuộc tấn công tiếp theo.

Chúng tôi xem xét tính chất hai mặt của AI và xem LLM đang được sử dụng cho cả mục đích xấu và tốt như thế nào.

Những điểm chínhĐối với các chuyên gia bảo mật. Tác động của AI có cả mặt tiêu cực và tích cực .

Tin tặc đang sử dụng GenAI để tăng cường khả năng khai thác và điều chỉnh kỹ thuật của mình.

Tuy nhiên, LLM cũng cung cấp cho các nhóm trung tâm điều hành bảo mật (SOC) những khả năng mới để ứng phó sự cố và quản lý lỗ hổng.

Sự phân đôi tốt/xấu của AI là một yếu tố khác mà các CSO cần cân nhắc khi họ phát triển cơ sở hạ tầng an ninh mạng để ứng phó với các mối đe dọa trong tương lai.

Những điều đó có thể bao gồm những phát triển mới nổi trong điện toán tình cảm và AI hiện thân , mà các chuyên gia tin rằng chúng ta cần theo dõi chặt chẽ để đảm bảo chúng không thể bị những kẻ xấu lợi dụng.

Bạn, kẻ thù hay cả hai?

Mỗi đột phá công nghệ đều mang lại mặt tích cực và tiêu cực. Một ứng dụng hứa hẹn năng suất cao hơn cũng có thể chín muồi để trở thành vũ khí, với AI tạo sinh là ví dụ hoàn hảo. Khả năng phân loại dữ liệu khổng lồ và nhanh chóng nhận ra các mẫu hữu ích đang thay đổi cách chúng ta làm việc và sáng tạo. GenAI cũng giúp tin tặc thực hiện các cuộc tấn công mà trước đây không thể thực hiện được .

AI đen tối này rất giỏi trong việc học và điều chỉnh các kỹ thuật của mình để xâm phạm hệ thống bảo mật. Trong khi AI tốt được sử dụng để cải thiện việc ra quyết định hoặc tự động hóa các tác vụ phức tạp, AI đen tối sử dụng sức mạnh của mình cho mục đích xấu, thay đổi dữ liệu, xâm nhập hệ thống và thực hiện các cuộc tấn công mạng.

Những kẻ xấu đã xây dựng các công cụ AI đen tối khai thác lỗ hổng mạng và thiết bị một cách nhanh chóng mà không bị phát hiện cho đến khi thiệt hại đã xảy ra.

Tội phạm mạng sử dụng AI như thế nào

Dan Ortega , Chiến lược gia bảo mật tại Anomali , nói với Techopedia rằng sự phát triển của AI đang khiến bối cảnh đe dọa "ngày càng phức tạp và khó quản lý và theo dõi. Các nhóm bảo mật hiện cần phải xem xét lại các công cụ họ đang sử dụng để thu thập và phân tích dữ liệu về mối đe dọa".

Ông cho biết AI có thể bổ sung các chức năng cho trung tâm điều hành bảo mật (SOC), “giảm bớt gánh nặng cho các nhà phân tích bảo mật bằng cách cung cấp khả năng liên tục thu thập và phân tích dữ liệu từ khắp môi trường CNTT, để đánh dấu các mối đe dọa trước khi chúng có thể gây ra thiệt hại”.

Kowski của SlashNext cho biết đây chính là tiềm năng thực sự của AI trong an ninh mạng – trong việc nâng cao chuyên môn của con người thay vì thay thế nó.

“Bằng cách tự động hóa các tác vụ thường lệ và cung cấp phân tích mối đe dọa nhanh chóng, AI trao quyền cho các nhóm bảo mật tập trung vào việc ra quyết định chiến lược và giải quyết vấn đề phức tạp. Các chiến lược bảo mật hiệu quả nhất kết hợp thông tin chi tiết do AI thúc đẩy với trực giác và kinh nghiệm của con người để tạo ra khả năng phòng thủ mạnh mẽ chống lại các mối đe dọa đang phát triển.”

Eric Schwake , Giám đốc Chiến lược An ninh mạng tại Salt Security , chia sẻ với Techopedia rằng các công cụ an ninh mạng hiện tại “có thể được cải thiện bằng AI để nhanh chóng lọc qua lưu lượng tương tự nhằm tìm ra nội dung thực sự độc hại, tự động hóa phản hồi sự cố và dự đoán các cuộc tấn công trong tương lai”.

Bao gồm SIEM , điều tra pháp y và các giải pháp phát hiện điểm cuối , khi các nhà cung cấp bảo mật nhanh chóng ứng phó với các mối đe dọa do AI điều khiển bằng các phản ứng được hỗ trợ bởi AI.

Nhưng Schwake cũng lưu ý rằng một loại công nghệ mới do AI thúc đẩy đang nổi lên, "được thiết kế riêng cho các trường hợp sử dụng bảo mật như phân tích mã , tình báo mối đe dọa và công nghệ lừa dối ".

Phân tích đóng vai trò cốt lõi của các nền tảng này, kết hợp dữ liệu, bảo mật và CNTT, đồng thời kết hợp GenAI và tự động hóa quy trình làm việc để ngăn chặn các cuộc tấn công trước khi chúng có thể gây ra thiệt hại.

Tim Ayling , Phó chủ tịch Giải pháp an ninh mạng EMEA của Imperva , đồng ý rằng các công cụ GenAI hạ thấp rào cản để bước vào thế giới tin tặc.

Ông cho biết: "Chúng tôi đã quan sát thấy những trường hợp bình luận về các lỗ hổng cụ thể được đăng trực tuyến được các công cụ này thu thập trong quá trình thu thập dữ liệu trên web và sau đó xây dựng dựa trên đó".

Việc xử lý thông tin nhạy cảm của các hệ thống AI tạo ra một cơ hội khác cho tội phạm mạng. Ayling nói thêm:

“Với lượng dữ liệu khổng lồ được xử lý, có nguy cơ dữ liệu nhạy cảm có thể bị tiết lộ một cách vô tình. Những kẻ đe dọa có thể lừa các hệ thống AI chia sẻ dữ liệu bí mật, chẳng hạn như hồ sơ khách hàng hoặc bí mật thương mại, dẫn đến vi phạm quyền riêng tư, các vấn đề pháp lý và tổn hại đến danh tiếng.”

Vai trò ngày càng phát triển của AI trong an ninh mạng

Trước đây, việc phát triển các khai thác tinh vi cần có ngân sách, trí tuệ và nguồn lực mà chỉ các tác nhân quốc gia mới có thể cung cấp. Ngày nay, AI đang trao những khả năng đó cho nhiều băng nhóm tội phạm và kẻ lừa đảo hơn. Bất chấp các biện pháp bảo vệ của những người đứng đầu GenAI như OpenAI nhằm ngăn chặn việc phát tán thông tin có khả năng gây hại, tin tặc vẫn tiếp tục khám phá ra những cách mới để vượt qua chúng.

Pappu của Zendata cho biết một kết quả của việc GenAI bị khai thác cho tội phạm mạng là các nhóm bảo mật đang "chìm trong tiếng ồn" từ các cảnh báo liên tục của hệ thống cảnh báo về các mối đe dọa tiềm ẩn. Trong bối cảnh khối lượng tín hiệu và kết quả dương tính giả ngày càng tăng, công nghệ AI và máy học cung cấp các giải pháp tiềm năng cho khối lượng công việc quá tải ... mặc dù phần lớn là do dark-AI điều khiển.

Các biện pháp phòng thủ mạng được hỗ trợ bởi AI có thể quét hoạt động mạng, xác định các điểm bất thường và ưu tiên cảnh báo. Nó có thể xử lý khối lượng dữ liệu khổng lồ, xác định nội dung đáng ngờ và cô lập các mối đe dọa. Chúng cũng hứa hẹn sẽ để các nhà phân tích SOC cấp cao rảnh tay tập trung vào các hoạt động chiến lược như phối hợp kiểm soát thiệt hại và chỉ đạo các hoạt động tấn công chiến thuật.

Những điều đó có thể bao gồm những phát triển mới nổi trong điện toán tình cảm và AI hiện thân , mà các chuyên gia tin rằng chúng ta cần theo dõi chặt chẽ để đảm bảo chúng không thể bị những kẻ xấu lợi dụng.

Bạn, kẻ thù hay cả hai?

Mỗi đột phá công nghệ đều mang lại mặt tích cực và tiêu cực. Một ứng dụng hứa hẹn năng suất cao hơn cũng có thể chín muồi để trở thành vũ khí, với AI tạo sinh là ví dụ hoàn hảo. Khả năng phân loại dữ liệu khổng lồ và nhanh chóng nhận ra các mẫu hữu ích đang thay đổi cách chúng ta làm việc và sáng tạo. GenAI cũng giúp tin tặc thực hiện các cuộc tấn công mà trước đây không thể thực hiện được .

AI đen tối này rất giỏi trong việc học và điều chỉnh các kỹ thuật của mình để xâm phạm hệ thống bảo mật. Trong khi AI tốt được sử dụng để cải thiện việc ra quyết định hoặc tự động hóa các tác vụ phức tạp, AI đen tối sử dụng sức mạnh của mình cho mục đích xấu, thay đổi dữ liệu, xâm nhập hệ thống và thực hiện các cuộc tấn công mạng.

Những kẻ xấu đã xây dựng các công cụ AI đen tối khai thác lỗ hổng mạng và thiết bị một cách nhanh chóng mà không bị phát hiện cho đến khi thiệt hại đã xảy ra.

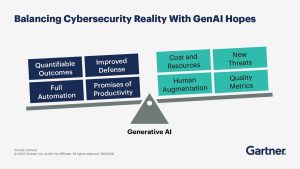

Sự cường điệu và hứa hẹn của AI trong an ninh mạng được cân bằng bởi sự lo lắng và rủi ro. Nguồn Gartner

Mặt tối của AI

Tổng giám đốc điều hành Zendata Narayana Pappu nói với Techopedia rằng deepfake khó phát hiện là một mối lo ngại nghiêm trọng . Gartner ước tính rằng deepfake sẽ trở nên thuyết phục trong hai năm tới đến mức 30% doanh nghiệp sẽ ngừng sử dụng sinh trắc học khuôn mặt để xác minh danh tính và xác thực.

Trong khi đó, các công cụ GenAI được thiết kế để hack đang "thích ứng với các hệ thống bảo mật và có thể học hỏi từ kết quả của các cuộc tấn công khác, cho phép phần mềm độc hại điều chỉnh chiến thuật một cách linh hoạt trong quá trình tấn công dựa trên phân tích thời gian thực về khả năng phòng thủ của mục tiêu".

Cùng nhau, chúng cho phép tin tặc hoạt động ở quy mô chưa từng thấy trước đây. Tuần trước, BT cho biết họ đã thu được khoảng 2.000 tín hiệu mỗi giây trên các mạng của mình, cho thấy một cuộc tấn công mạng tiềm ẩn. Điều này chỉ ra một cuộc chạy đua "vũ khí AI" khi tin tặc ngày càng tinh vi tìm cách vượt mặt nhau trong việc xác định các khai thác mới. Trong năm qua, các kỹ sư của BT đã chứng kiến sự gia tăng đột biến 1.200% trong các bot quét cố gắng truy cập vào hệ thống của mình .

Tuy nhiên, các công cụ AI không nhất thiết phải được sử dụng như vũ khí để hỗ trợ hoạt động tội phạm; việc sử dụng chúng trong phân tích mang lại rất nhiều lợi ích.

Stephen Kowski , Giám đốc công nghệ tại SlashNext Email Security , chia sẻ với Techopedia rằng trong khi sự tham gia trực tiếp của AI vào các cuộc tấn công đang thu hút sự chú ý, thì “mối đe dọa thực sự nằm ở khả năng mở rộng quy mô và tinh chỉnh các kiểu tấn công hiện có của AI.

"Chúng tôi đang chứng kiến sự gia tăng các cuộc tấn công đa kênh không dựa vào AI tiên tiến để thực hiện mà được hưởng lợi từ đầu vào sáng tạo của AI trong thiết kế", ông nói. "Việc sử dụng AI gián tiếp này cho phép tội phạm mạng tạo ra các chiến dịch tấn công thuyết phục hơn, rộng rãi hơn và dễ thích ứng hơn".

Tổng giám đốc điều hành Zendata Narayana Pappu nói với Techopedia rằng deepfake khó phát hiện là một mối lo ngại nghiêm trọng . Gartner ước tính rằng deepfake sẽ trở nên thuyết phục trong hai năm tới đến mức 30% doanh nghiệp sẽ ngừng sử dụng sinh trắc học khuôn mặt để xác minh danh tính và xác thực.

Trong khi đó, các công cụ GenAI được thiết kế để hack đang "thích ứng với các hệ thống bảo mật và có thể học hỏi từ kết quả của các cuộc tấn công khác, cho phép phần mềm độc hại điều chỉnh chiến thuật một cách linh hoạt trong quá trình tấn công dựa trên phân tích thời gian thực về khả năng phòng thủ của mục tiêu".

Cùng nhau, chúng cho phép tin tặc hoạt động ở quy mô chưa từng thấy trước đây. Tuần trước, BT cho biết họ đã thu được khoảng 2.000 tín hiệu mỗi giây trên các mạng của mình, cho thấy một cuộc tấn công mạng tiềm ẩn. Điều này chỉ ra một cuộc chạy đua "vũ khí AI" khi tin tặc ngày càng tinh vi tìm cách vượt mặt nhau trong việc xác định các khai thác mới. Trong năm qua, các kỹ sư của BT đã chứng kiến sự gia tăng đột biến 1.200% trong các bot quét cố gắng truy cập vào hệ thống của mình .

Tuy nhiên, các công cụ AI không nhất thiết phải được sử dụng như vũ khí để hỗ trợ hoạt động tội phạm; việc sử dụng chúng trong phân tích mang lại rất nhiều lợi ích.

Stephen Kowski , Giám đốc công nghệ tại SlashNext Email Security , chia sẻ với Techopedia rằng trong khi sự tham gia trực tiếp của AI vào các cuộc tấn công đang thu hút sự chú ý, thì “mối đe dọa thực sự nằm ở khả năng mở rộng quy mô và tinh chỉnh các kiểu tấn công hiện có của AI.

"Chúng tôi đang chứng kiến sự gia tăng các cuộc tấn công đa kênh không dựa vào AI tiên tiến để thực hiện mà được hưởng lợi từ đầu vào sáng tạo của AI trong thiết kế", ông nói. "Việc sử dụng AI gián tiếp này cho phép tội phạm mạng tạo ra các chiến dịch tấn công thuyết phục hơn, rộng rãi hơn và dễ thích ứng hơn".

Tội phạm mạng sử dụng AI như thế nào

Tự động tấn côngCác cuộc tấn công mạng tinh vi thường đòi hỏi một tin tặc con người để điều khiển chúng. Các công cụ hỗ trợ GenAI cho phép kẻ thù tự động hóa cách thực hiện các cuộc tấn công và phản ứng với các thách thức theo thời gian thực.

Thu thập dữ liệu hiệu quả hơn

Mọi cuộc tấn công mạng đều bắt đầu bằng giai đoạn nghiên cứu, trong đó kẻ xấu quét các lỗ hổng có thể khai thác và tìm kiếm thông tin có giá trị đánh cắp. AI có thể đẩy nhanh giai đoạn trinh sát này bằng cách thực hiện nhiệm vụ nặng nề là xác định các mục tiêu tiềm năng và cải thiện độ chính xác của phân tích.

Tùy chỉnh tin nhắn

GenAI thường xuyên thu thập một lượng lớn dữ liệu cá nhân từ các nguồn công khai như trang web công ty và tài khoản mạng xã hội. Tội phạm mạng có thể biến điều đó thành khả năng AI đen tối bằng cách tạo ra các thông điệp siêu cá nhân hóa khiến email và cuộc gọi lừa đảo trở nên hợp lý và hiệu quả hơn.

Học tăng cường

Các mô hình ngôn ngữ lớn được thiết kế để học và thích ứng theo thời gian thực, một khả năng mà kẻ tấn công có thể sử dụng để xác định các kỹ thuật đột nhập hiệu quả nhất hoặc cách tốt nhất để tránh bị phát hiện.

Nhắm mục tiêu nhân viên

Các công cụ AI có thể giúp xác định các mục tiêu có giá trị cao nhất trong một doanh nghiệp. Họ có thể là giám đốc điều hành, những người có quyền truy cập vào dữ liệu độc quyền hoặc nhân viên CNTT có quyền truy cập hệ thống rộng rãi. AI cũng có thể được sử dụng để tìm ra các mối đe dọa nội gián - những người có trình độ hiểu biết kỹ thuật thấp hơn hoặc có hành vi không an toàn.

AI vì mục đích tốt đẹp

Dan Ortega , Chiến lược gia bảo mật tại Anomali , nói với Techopedia rằng sự phát triển của AI đang khiến bối cảnh đe dọa "ngày càng phức tạp và khó quản lý và theo dõi. Các nhóm bảo mật hiện cần phải xem xét lại các công cụ họ đang sử dụng để thu thập và phân tích dữ liệu về mối đe dọa".

Ông cho biết AI có thể bổ sung các chức năng cho trung tâm điều hành bảo mật (SOC), “giảm bớt gánh nặng cho các nhà phân tích bảo mật bằng cách cung cấp khả năng liên tục thu thập và phân tích dữ liệu từ khắp môi trường CNTT, để đánh dấu các mối đe dọa trước khi chúng có thể gây ra thiệt hại”.

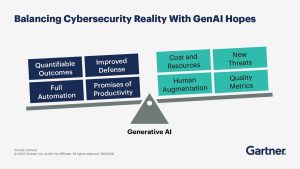

Tác động của GenAI đối với CISO. Nguồn: Gartner

Kowski của SlashNext cho biết đây chính là tiềm năng thực sự của AI trong an ninh mạng – trong việc nâng cao chuyên môn của con người thay vì thay thế nó.

“Bằng cách tự động hóa các tác vụ thường lệ và cung cấp phân tích mối đe dọa nhanh chóng, AI trao quyền cho các nhóm bảo mật tập trung vào việc ra quyết định chiến lược và giải quyết vấn đề phức tạp. Các chiến lược bảo mật hiệu quả nhất kết hợp thông tin chi tiết do AI thúc đẩy với trực giác và kinh nghiệm của con người để tạo ra khả năng phòng thủ mạnh mẽ chống lại các mối đe dọa đang phát triển.”

Eric Schwake , Giám đốc Chiến lược An ninh mạng tại Salt Security , chia sẻ với Techopedia rằng các công cụ an ninh mạng hiện tại “có thể được cải thiện bằng AI để nhanh chóng lọc qua lưu lượng tương tự nhằm tìm ra nội dung thực sự độc hại, tự động hóa phản hồi sự cố và dự đoán các cuộc tấn công trong tương lai”.

Bao gồm SIEM , điều tra pháp y và các giải pháp phát hiện điểm cuối , khi các nhà cung cấp bảo mật nhanh chóng ứng phó với các mối đe dọa do AI điều khiển bằng các phản ứng được hỗ trợ bởi AI.

Nhưng Schwake cũng lưu ý rằng một loại công nghệ mới do AI thúc đẩy đang nổi lên, "được thiết kế riêng cho các trường hợp sử dụng bảo mật như phân tích mã , tình báo mối đe dọa và công nghệ lừa dối ".

Phân tích đóng vai trò cốt lõi của các nền tảng này, kết hợp dữ liệu, bảo mật và CNTT, đồng thời kết hợp GenAI và tự động hóa quy trình làm việc để ngăn chặn các cuộc tấn công trước khi chúng có thể gây ra thiệt hại.

Mặt trái của LLM

Làm phức tạp thêm bức tranh là thực tế là GenAI có những lỗ hổng độc đáo riêng mà tin tặc đang tích cực thăm dò. Nhiều lỗ hổng có thể tiếp cận được với những người không phải là chuyên gia kỹ thuật, tạo ra một loại tội phạm mạng 'không chuyên' mới có thể thực hiện các cuộc tấn công mà nếu không thì họ sẽ phải vật lộn để thực hiện.

Những điều này có thể bao gồm:

Làm phức tạp thêm bức tranh là thực tế là GenAI có những lỗ hổng độc đáo riêng mà tin tặc đang tích cực thăm dò. Nhiều lỗ hổng có thể tiếp cận được với những người không phải là chuyên gia kỹ thuật, tạo ra một loại tội phạm mạng 'không chuyên' mới có thể thực hiện các cuộc tấn công mà nếu không thì họ sẽ phải vật lộn để thực hiện.

Những điều này có thể bao gồm:

Tấn công tiêm nhanh

Một loại tấn công xảy ra khi các hướng dẫn đặc biệt được đưa ra cho lời nhắc GenAI lành tính để định hình đầu ra của mô hình cho mục đích xấu.

Bẻ khóa

Một dạng tiêm nhắc nhở được thiết kế để làm suy yếu chức năng của chatbot do LLM điều khiển. Một nhắc nhở được tạo ra với các hướng dẫn được thiết kế để vô hiệu hóa các tính năng an toàn và kiểm duyệt của LLM.

Dữ liệu đào tạo về ngộ độc

Làm hỏng dữ liệu đào tạo của LLM để tạo ra các đầu ra độc hại. Điều này có thể bao gồm việc chèn dữ liệu bị thao túng hoặc không chính xác vào tập dữ liệu đào tạo của mô hình để thay đổi hành vi của nó.

Tấn công chuỗi cung ứng LLM

Nơi tội phạm nhắm mục tiêu và xâm phạm các thư viện phần mềm, phần phụ thuộc và công cụ phát triển của bên thứ ba được sử dụng để tạo ra các công cụ GenAI.

Các cuộc tấn công Crescendo

Một hình thức tấn công mới hơn mượn ý tưởng từ kỹ thuật xã hội . Chúng vượt qua các biện pháp an toàn của LLM bằng cách bắt đầu bằng những lời nhắc nhở lành tính rồi dần dần thêm các mũi tiêm, tránh kích hoạt các biện pháp phòng thủ.

Tim Ayling , Phó chủ tịch Giải pháp an ninh mạng EMEA của Imperva , đồng ý rằng các công cụ GenAI hạ thấp rào cản để bước vào thế giới tin tặc.

Ông cho biết: "Chúng tôi đã quan sát thấy những trường hợp bình luận về các lỗ hổng cụ thể được đăng trực tuyến được các công cụ này thu thập trong quá trình thu thập dữ liệu trên web và sau đó xây dựng dựa trên đó".

Việc xử lý thông tin nhạy cảm của các hệ thống AI tạo ra một cơ hội khác cho tội phạm mạng. Ayling nói thêm:

“Với lượng dữ liệu khổng lồ được xử lý, có nguy cơ dữ liệu nhạy cảm có thể bị tiết lộ một cách vô tình. Những kẻ đe dọa có thể lừa các hệ thống AI chia sẻ dữ liệu bí mật, chẳng hạn như hồ sơ khách hàng hoặc bí mật thương mại, dẫn đến vi phạm quyền riêng tư, các vấn đề pháp lý và tổn hại đến danh tiếng.”

3 mối đe dọa hàng đầu trong tương lai

Trong khi các nhà phát triển đang nỗ lực vá các điểm yếu bảo mật tích hợp của GenAI, một loạt các mối lo ngại mới về an ninh mạng đang xuất hiện. Các chuyên gia chỉ ra những xu hướng AI mới nổi hoặc 'gần giống AI' này là những xu hướng cần chú ý:

Trong khi các nhà phát triển đang nỗ lực vá các điểm yếu bảo mật tích hợp của GenAI, một loạt các mối lo ngại mới về an ninh mạng đang xuất hiện. Các chuyên gia chỉ ra những xu hướng AI mới nổi hoặc 'gần giống AI' này là những xu hướng cần chú ý:

1. AI đại lý

Sự phát triển của các công cụ GenAI cuối cùng sẽ tạo ra một Internet of Agents hay IOA, một mạng lưới tích hợp sâu các ứng dụng AI-to-AI hoặc 'agent' tương tác trực tiếp với nhau, hoàn thành nhiệm vụ và thực hiện các giao dịch phức tạp, nhiều bước với sự can thiệp tối thiểu của con người

Rủi ro là một công cụ AI được giao nhiệm vụ quản lý danh mục đầu tư chứng khoán, sắp xếp công tác đi lại hoặc thực hiện các chiến dịch tiếp thị có thể bị bên thứ ba xâm phạm.

2. AI hiện thân

Về chủ đề tương tự, bất kỳ ai xem video về sự ra mắt gần đây của nền tảng robot AI của NVIDIA sẽ bị ấn tượng bởi các robot demo và khả năng tương tác với thế giới vật lý bằng các kỹ năng vận động tinh của chúng. Robot đang được thiết kế để tương tác với các robot khác, LLM và con người.

Không ai có thể bỏ qua khả năng một robot khỏe mạnh, nhanh nhẹn và có khả năng di chuyển độc lập có thể bị tin tặc tấn công và biến thành thây ma.3. Máy tính tình cảm

Giới học thuật đang đạt được tiến bộ trong việc tạo ra những tương tác trực quan và cá nhân hóa hơn giữa con người và phần mềm. Nói một cách đơn giản nhất, điện toán tình cảm nhằm mục đích tạo ra những cỗ máy có thể hiểu và phản ứng với cảm xúc của con người – tự nhiên khiến chúng khó phân biệt với người Homo sapiens bằng xương bằng thịt thực sự.

Chúng ta đã thấy deepfake có khả năng lừa kế toán viên thực hiện chuyển tiền quốc tế giả mạo. Hãy tưởng tượng xem những kẻ lừa đảo có thể thực hiện những gì khác với công nghệ giống con người hơn con người để làm việc?

Vai trò ngày càng phát triển của AI trong an ninh mạng

Trước đây, việc phát triển các khai thác tinh vi cần có ngân sách, trí tuệ và nguồn lực mà chỉ các tác nhân quốc gia mới có thể cung cấp. Ngày nay, AI đang trao những khả năng đó cho nhiều băng nhóm tội phạm và kẻ lừa đảo hơn. Bất chấp các biện pháp bảo vệ của những người đứng đầu GenAI như OpenAI nhằm ngăn chặn việc phát tán thông tin có khả năng gây hại, tin tặc vẫn tiếp tục khám phá ra những cách mới để vượt qua chúng.

Pappu của Zendata cho biết một kết quả của việc GenAI bị khai thác cho tội phạm mạng là các nhóm bảo mật đang "chìm trong tiếng ồn" từ các cảnh báo liên tục của hệ thống cảnh báo về các mối đe dọa tiềm ẩn. Trong bối cảnh khối lượng tín hiệu và kết quả dương tính giả ngày càng tăng, công nghệ AI và máy học cung cấp các giải pháp tiềm năng cho khối lượng công việc quá tải ... mặc dù phần lớn là do dark-AI điều khiển.

Các biện pháp phòng thủ mạng được hỗ trợ bởi AI có thể quét hoạt động mạng, xác định các điểm bất thường và ưu tiên cảnh báo. Nó có thể xử lý khối lượng dữ liệu khổng lồ, xác định nội dung đáng ngờ và cô lập các mối đe dọa. Chúng cũng hứa hẹn sẽ để các nhà phân tích SOC cấp cao rảnh tay tập trung vào các hoạt động chiến lược như phối hợp kiểm soát thiệt hại và chỉ đạo các hoạt động tấn công chiến thuật.

Điểm mấu chốt: Xây dựng hệ thống an ninh đa lớp, bền vững

Stephen Kowski của SlashNext cho biết, hiện tại, “Các CSO nên ưu tiên giải quyết các rủi ro hiện tại do vai trò hỗ trợ của AI trong thiết kế tấn công gây ra.

“Mối quan tâm trước mắt không tập trung nhiều vào các tác nhân AI tự động, mà là vào khả năng sáng tạo và hiệu quả được AI nâng cao dành cho những kẻ tấn công là con người. Tập trung vào việc xây dựng các hệ thống bảo mật nhiều lớp, có khả năng phục hồi, có thể thích ứng với nhiều vectơ tấn công khác nhau là rất quan trọng trong môi trường đe dọa đang phát triển này.”

In the fight against cybercrime, AI is both a rising threat and a potential new ally.

While large language models (LLMs) can blur the lines between authentic users and imposters, they can also help CSOs find hidden vulnerabilities and predict where the next attack might land.

We examine AI’s cyber-duality and look at how LLMs are being used for both bad – and good.

Key TakeawaysFor security professionals. AI’s impact has negatives and positives.

Hackers are using GenAI to power up their exploits and adapt their techniques.

Yet LLMs are also giving security operations center (SOC) teams new capabilities for incident response and vulnerability management.

AI’s good/bad dichotomy is another factor CSOs need to weigh as they evolve cybersecurity infrastructure for future threats.

Those could include emerging developments in affective computing and embodied AI, which experts believe we need to watch closely to ensure they can’t be weaponized by bad actors.

Friend, Enemy, or Both?

Table of Contents

Friend, Enemy, or Both?

Every tech breakthrough brings positives and negatives. An application promising greater productivity could also be ripe for weaponization, with generative AI providing the perfect example. Its ability to sort through massive amounts of data and quickly recognize useful patterns is changing how we work and create. GenAI is also helping hackers mount attacks that weren’t possible before.

This dark AI is adept at learning and adapting its techniques to breach security systems. Where good AI is used to improve decision-making or automate complex tasks, dark AI uses its powers for evil, altering data, infiltrating systems, and conducting cyberattacks.

Bad actors have already built dark AI tools that exploit network and device vulnerabilities at speed, going unnoticed until the damage is already done.

Stephen Kowski của SlashNext cho biết, hiện tại, “Các CSO nên ưu tiên giải quyết các rủi ro hiện tại do vai trò hỗ trợ của AI trong thiết kế tấn công gây ra.

“Mối quan tâm trước mắt không tập trung nhiều vào các tác nhân AI tự động, mà là vào khả năng sáng tạo và hiệu quả được AI nâng cao dành cho những kẻ tấn công là con người. Tập trung vào việc xây dựng các hệ thống bảo mật nhiều lớp, có khả năng phục hồi, có thể thích ứng với nhiều vectơ tấn công khác nhau là rất quan trọng trong môi trường đe dọa đang phát triển này.”

How the Two Faces of AI Are Forcing a Cyber Re-Think

In the fight against cybercrime, AI is both a rising threat and a potential new ally.

While large language models (LLMs) can blur the lines between authentic users and imposters, they can also help CSOs find hidden vulnerabilities and predict where the next attack might land.

We examine AI’s cyber-duality and look at how LLMs are being used for both bad – and good.

Key TakeawaysFor security professionals. AI’s impact has negatives and positives.

Hackers are using GenAI to power up their exploits and adapt their techniques.

Yet LLMs are also giving security operations center (SOC) teams new capabilities for incident response and vulnerability management.

AI’s good/bad dichotomy is another factor CSOs need to weigh as they evolve cybersecurity infrastructure for future threats.

Those could include emerging developments in affective computing and embodied AI, which experts believe we need to watch closely to ensure they can’t be weaponized by bad actors.

Friend, Enemy, or Both?

Table of Contents

Friend, Enemy, or Both?

Every tech breakthrough brings positives and negatives. An application promising greater productivity could also be ripe for weaponization, with generative AI providing the perfect example. Its ability to sort through massive amounts of data and quickly recognize useful patterns is changing how we work and create. GenAI is also helping hackers mount attacks that weren’t possible before.

This dark AI is adept at learning and adapting its techniques to breach security systems. Where good AI is used to improve decision-making or automate complex tasks, dark AI uses its powers for evil, altering data, infiltrating systems, and conducting cyberattacks.

Bad actors have already built dark AI tools that exploit network and device vulnerabilities at speed, going unnoticed until the damage is already done.

AI’s hype and promise in cybersecurity is balanced by trepidation and risk. Source Gartner

AI’s Darkside

Zendata CEO Narayana Pappu told Techopedia that hard-to-detect deepfakes are one serious concern. Gartner reckons that deepfakes will become so convincing in the next two years that 30% of enterprises will stop using facial biometrics altogether for identity verification and authentication.

Meanwhile, GenAI tools designed for hacking are “adapting to security systems and can learn from the results of other attacks, allowing malware to dynamically adjust tactics during an attack based on real-time analysis of the target’s defenses.”

Together, they’re enabling hackers to operate at a scale not seen before. Last week, BT said it was capturing roughly 2,000 signals per second across its networks, indicating a potential cyberattack. This points to an “AI arms” race as increasingly sophisticated hackers seek to out-compete one another in identifying new exploits. In the past year, BT engineers have seen a meteoric 1,200% increase in scanning bots attempting to access its systems.

However, AI tools don’t have to be weaponized to assist in criminal activity; their use in analytics provides ample benefits.

Stephen Kowski, Field CTO at SlashNext Email Security, told Techopedia that while direct AI involvement in attacks grabs headlines, “the real threat lies in AI’s ability to scale and refine existing attack patterns.

“We’re seeing a surge in multichannel attacks that don’t rely on advanced AI for execution but benefit from its creative input in design,” he says. “This indirect use of AI allows cybercriminals to craft more convincing, widespread, and adaptable attack campaigns.”

How Cybercriminals Use AI

Automating Attacks

Sophisticated cyberattacks normally require a human hacker to drive them forward. GenAI-enabled tools enable adversaries to automate how attacks are executed and respond to challenges in real time.

Gathering Data More Efficiently

Every cyberattack starts with a research phase, where bad actors scan for exploitable vulnerabilities and look for information assets worth stealing. AI can accelerate this reconnaissance phase by doing the heavy lifting of identifying potential targets and improving the accuracy of analysis.

Customizing Messages

GenAI routinely scrapes massive amounts of personal data from public sources like company websites and social media accounts. Cybercriminals can turn that into a dark AI capability by crafting hyper-personalized messages that make phishing emails and calls more plausible and effective.

Reinforcement Learning

Large language models are designed to learn and adapt in real-time, a capability that threat actors can use to identify the most effective break-in techniques or the best ways to avoid being detected.

Targeting Employees

AI tools can help identify the most high-value targets inside a business. They might be executives, people with access to proprietary data, or IT staff with wide system access. AI can also be used to find insider threats – people who have a lower degree of technical comprehension or exhibit unsafe behaviors.

AI for Good

Dan Ortega, Security Strategist at Anomali, told Techopedia that the proliferation of AI is making the threat landscape “increasingly complex and difficult to manage and track. Security teams now need to rethink what tools they’re using to gather and analyze threat data.”

He says AI can add capabilities in the security operations center (SOC), “taking the load off of security analysts by providing the ability to continuously gather and analyze data from across the IT environment, to flag threats before they can create damage.”

AI’s Darkside

Zendata CEO Narayana Pappu told Techopedia that hard-to-detect deepfakes are one serious concern. Gartner reckons that deepfakes will become so convincing in the next two years that 30% of enterprises will stop using facial biometrics altogether for identity verification and authentication.

Meanwhile, GenAI tools designed for hacking are “adapting to security systems and can learn from the results of other attacks, allowing malware to dynamically adjust tactics during an attack based on real-time analysis of the target’s defenses.”

Together, they’re enabling hackers to operate at a scale not seen before. Last week, BT said it was capturing roughly 2,000 signals per second across its networks, indicating a potential cyberattack. This points to an “AI arms” race as increasingly sophisticated hackers seek to out-compete one another in identifying new exploits. In the past year, BT engineers have seen a meteoric 1,200% increase in scanning bots attempting to access its systems.

However, AI tools don’t have to be weaponized to assist in criminal activity; their use in analytics provides ample benefits.

Stephen Kowski, Field CTO at SlashNext Email Security, told Techopedia that while direct AI involvement in attacks grabs headlines, “the real threat lies in AI’s ability to scale and refine existing attack patterns.

“We’re seeing a surge in multichannel attacks that don’t rely on advanced AI for execution but benefit from its creative input in design,” he says. “This indirect use of AI allows cybercriminals to craft more convincing, widespread, and adaptable attack campaigns.”

How Cybercriminals Use AI

Automating Attacks

Sophisticated cyberattacks normally require a human hacker to drive them forward. GenAI-enabled tools enable adversaries to automate how attacks are executed and respond to challenges in real time.

Gathering Data More Efficiently

Every cyberattack starts with a research phase, where bad actors scan for exploitable vulnerabilities and look for information assets worth stealing. AI can accelerate this reconnaissance phase by doing the heavy lifting of identifying potential targets and improving the accuracy of analysis.

Customizing Messages

GenAI routinely scrapes massive amounts of personal data from public sources like company websites and social media accounts. Cybercriminals can turn that into a dark AI capability by crafting hyper-personalized messages that make phishing emails and calls more plausible and effective.

Reinforcement Learning

Large language models are designed to learn and adapt in real-time, a capability that threat actors can use to identify the most effective break-in techniques or the best ways to avoid being detected.

Targeting Employees

AI tools can help identify the most high-value targets inside a business. They might be executives, people with access to proprietary data, or IT staff with wide system access. AI can also be used to find insider threats – people who have a lower degree of technical comprehension or exhibit unsafe behaviors.

AI for Good

Dan Ortega, Security Strategist at Anomali, told Techopedia that the proliferation of AI is making the threat landscape “increasingly complex and difficult to manage and track. Security teams now need to rethink what tools they’re using to gather and analyze threat data.”

He says AI can add capabilities in the security operations center (SOC), “taking the load off of security analysts by providing the ability to continuously gather and analyze data from across the IT environment, to flag threats before they can create damage.”

Impact of GenAI for CISOs. Source: Gartner

SlashNext’s Kowski says this is where AI’s true potential in cybersecurity lies – in enhancing human expertise rather than replacing it.

“By automating routine tasks and providing rapid threat analysis, AI empowers security teams to focus on strategic decision-making and complex problem-solving. The most effective security strategies combine AI-driven insights with human intuition and experience to create a robust defense against evolving threats.”

Eric Schwake, Director of Cybersecurity Strategy at Salt Security, told Techopedia that current cybersecurity tools “can be improved with AI to quickly filter through analogues traffic to find what’s truly malicious, automate incident response, and predict future attacks.”

That includes SIEM, forensic investigation and endpoint detection solutions, as security vendors rush to meet AI-driven threats with AI-powered responses.

But Schwake also notes that a new class of AI-driven technologies is emerging, “specifically designed for security use cases like code analysis, threat intelligence, and deception technologies.”

Analytics sit at the core of these platforms, which take the convergence of data, security, and IT and blend in GenAI and workflow automation to stop attacks before they can do damage.

The Soft Underbelly of LLMs

Complicating the picture is the fact that GenAI has its own unique vulnerabilities that hackers are actively probing. Many are accessible to non-technical actors, creating a new category of ‘layman’ cybercriminals who can mount attacks they would otherwise struggle to execute.

These can include:

Prompt Injection Attacks

A type of attack that occurs when special instructions are given to an otherwise benign GenAI prompt to shape the model’s output for malicious purposes.

Jailbreaking

A form of prompt injection designed to undermine the function of LLM-driven chatbots. A prompt is created with instructions designed to disable LLM safety and moderation features.

Poisoning Training Data

Corrupting an LLM’s training data to create malicious outputs. This could involve inserting manipulated or incorrect data into a model’s training dataset to alter its behavior.

LLM Supply Chain Attacks

Where criminals target and compromise third-party software libraries, dependencies, and development tools used to create GenAI tools.

Crescendo Attacks

A newer form of attack that borrows ideas from social engineering. They get around LLM safety measures by starting with benign prompts and then gradually adding injections, avoiding triggering defenses.

Tim Ayling, VP Cyber Security Solutions EMEA for Imperva, agrees that GenAI tools lower the bar for entering the hacking world.

“We’ve observed instances where comments about specific exploits posted online are picked up by these tools during web crawling and then built upon,” he said.

The handling of sensitive information by AI systems presents another opportunity for cybercriminals. Ayling added:

“With the vast amounts of data processed, there’s a risk that sensitive data could be inadvertently revealed. Threat actors might trick AI systems into sharing confidential data, such as customer records or trade secrets, leading to privacy breaches, legal issues, and reputational damage.”

Top 3 Future Threats

While developers work to patch up GenAI’s in-built security weaknesses, a new set of cyber worries is on the horizon. Experts point to these emerging AI or ‘AI-adjacent’ trends as the ones to watch:

1. Agentic AI

The proliferation of GenAI tools will eventually create an Internet of Agents or IOA, a deeply integrated network of AI-to-AI applications or ‘agents’ that interact directly with each other, completing tasks and executing complex, multi-step transactions with minimal human intervention

The risk is that an AI tool tasked with, say, managing stock portfolios, making travel arrangements, or executing marketing campaigns could be compromised by third parties.

2. Embodied AI

On a similar theme, anyone watching the video for the recent launch of NVIDIA’s AI-driven robotics platform will be struck by the demo robots and their ability to interact with the physical world using fine motor skills. Robots are being designed to interact with other robots, LLMs, and humans.

The potential for a physically strong, fast, and independently-mobile robot to be hacked and zombie-fied by a threat actor won’t be lost on anyone.

3. Affective Computing

Academics are making progress in creating more personalized and intuitive interactions between people and software. In the simplest terms, affective computing aims to create machines that understand and respond to human emotions – naturally making them harder to distinguish from real flesh & blood homo sapiens.

We’re already seeing deepfakes capable of tricking accountants into making bogus international cash transfers. Imagine what else fraudsters might be able to perpetrate with more-human-than-human technologies to work with?

The Evolving Role of AI in Cybersecurity

In the past, developing sophisticated exploits needed budgets, brainpower, and resources only nation-state actors could provide. Today, AI is handing those capabilities to a wider array of criminal gangs and fraudsters. Despite safeguards by GenAI leaders like OpenAI to stop the spread of potentially harmful information, hackers keep discovering new ways to get around them.

Zendata’s Pappu says one result of GenAI being harnessed for cybercrime is that security teams are ‘drowning in noise’ from continual system alerts warning of potential threats. Amid a growing volume of signals and false positives, AI and machine learning technologies offer potential solutions to an overwhelming workload … though much of it is dark-AI-driven.

AI-powered cyber defenses can scan network activity, pinpoint anomalies and prioritize alerts. It can pore over huge volumes of data, identify suspicious content and isolate threats. They also promise to leave senior SOC analysts free to focus on strategic activities like coordinating damage control and directing tactical offensive operations.

The Bottom Line: Building Resilient, Multi-Layered Security

SlashNext’s Stephen Kowski says that, for now, “CSOs should prioritize addressing current risks amplified by AI’s supporting role in attack design.

“The immediate concern is less focused on autonomous AI agents, but rather on the enhanced creativity and efficiency AI lends to human attackers. Focusing on building resilient, multi-layered security systems that can adapt to diverse attack vectors is crucial in this evolving threat environment.”

Nguồn: https://www.techopedia.com/ai-forces-a-cyber-rethink

SlashNext’s Kowski says this is where AI’s true potential in cybersecurity lies – in enhancing human expertise rather than replacing it.

“By automating routine tasks and providing rapid threat analysis, AI empowers security teams to focus on strategic decision-making and complex problem-solving. The most effective security strategies combine AI-driven insights with human intuition and experience to create a robust defense against evolving threats.”

Eric Schwake, Director of Cybersecurity Strategy at Salt Security, told Techopedia that current cybersecurity tools “can be improved with AI to quickly filter through analogues traffic to find what’s truly malicious, automate incident response, and predict future attacks.”

That includes SIEM, forensic investigation and endpoint detection solutions, as security vendors rush to meet AI-driven threats with AI-powered responses.

But Schwake also notes that a new class of AI-driven technologies is emerging, “specifically designed for security use cases like code analysis, threat intelligence, and deception technologies.”

Analytics sit at the core of these platforms, which take the convergence of data, security, and IT and blend in GenAI and workflow automation to stop attacks before they can do damage.

The Soft Underbelly of LLMs

Complicating the picture is the fact that GenAI has its own unique vulnerabilities that hackers are actively probing. Many are accessible to non-technical actors, creating a new category of ‘layman’ cybercriminals who can mount attacks they would otherwise struggle to execute.

These can include:

Prompt Injection Attacks

A type of attack that occurs when special instructions are given to an otherwise benign GenAI prompt to shape the model’s output for malicious purposes.

Jailbreaking

A form of prompt injection designed to undermine the function of LLM-driven chatbots. A prompt is created with instructions designed to disable LLM safety and moderation features.

Poisoning Training Data

Corrupting an LLM’s training data to create malicious outputs. This could involve inserting manipulated or incorrect data into a model’s training dataset to alter its behavior.

LLM Supply Chain Attacks

Where criminals target and compromise third-party software libraries, dependencies, and development tools used to create GenAI tools.

Crescendo Attacks

A newer form of attack that borrows ideas from social engineering. They get around LLM safety measures by starting with benign prompts and then gradually adding injections, avoiding triggering defenses.

Tim Ayling, VP Cyber Security Solutions EMEA for Imperva, agrees that GenAI tools lower the bar for entering the hacking world.

“We’ve observed instances where comments about specific exploits posted online are picked up by these tools during web crawling and then built upon,” he said.

The handling of sensitive information by AI systems presents another opportunity for cybercriminals. Ayling added:

“With the vast amounts of data processed, there’s a risk that sensitive data could be inadvertently revealed. Threat actors might trick AI systems into sharing confidential data, such as customer records or trade secrets, leading to privacy breaches, legal issues, and reputational damage.”

Top 3 Future Threats

While developers work to patch up GenAI’s in-built security weaknesses, a new set of cyber worries is on the horizon. Experts point to these emerging AI or ‘AI-adjacent’ trends as the ones to watch:

1. Agentic AI

The proliferation of GenAI tools will eventually create an Internet of Agents or IOA, a deeply integrated network of AI-to-AI applications or ‘agents’ that interact directly with each other, completing tasks and executing complex, multi-step transactions with minimal human intervention

The risk is that an AI tool tasked with, say, managing stock portfolios, making travel arrangements, or executing marketing campaigns could be compromised by third parties.

2. Embodied AI

On a similar theme, anyone watching the video for the recent launch of NVIDIA’s AI-driven robotics platform will be struck by the demo robots and their ability to interact with the physical world using fine motor skills. Robots are being designed to interact with other robots, LLMs, and humans.

The potential for a physically strong, fast, and independently-mobile robot to be hacked and zombie-fied by a threat actor won’t be lost on anyone.

3. Affective Computing

Academics are making progress in creating more personalized and intuitive interactions between people and software. In the simplest terms, affective computing aims to create machines that understand and respond to human emotions – naturally making them harder to distinguish from real flesh & blood homo sapiens.

We’re already seeing deepfakes capable of tricking accountants into making bogus international cash transfers. Imagine what else fraudsters might be able to perpetrate with more-human-than-human technologies to work with?

The Evolving Role of AI in Cybersecurity

In the past, developing sophisticated exploits needed budgets, brainpower, and resources only nation-state actors could provide. Today, AI is handing those capabilities to a wider array of criminal gangs and fraudsters. Despite safeguards by GenAI leaders like OpenAI to stop the spread of potentially harmful information, hackers keep discovering new ways to get around them.

Zendata’s Pappu says one result of GenAI being harnessed for cybercrime is that security teams are ‘drowning in noise’ from continual system alerts warning of potential threats. Amid a growing volume of signals and false positives, AI and machine learning technologies offer potential solutions to an overwhelming workload … though much of it is dark-AI-driven.

AI-powered cyber defenses can scan network activity, pinpoint anomalies and prioritize alerts. It can pore over huge volumes of data, identify suspicious content and isolate threats. They also promise to leave senior SOC analysts free to focus on strategic activities like coordinating damage control and directing tactical offensive operations.

The Bottom Line: Building Resilient, Multi-Layered Security

SlashNext’s Stephen Kowski says that, for now, “CSOs should prioritize addressing current risks amplified by AI’s supporting role in attack design.

“The immediate concern is less focused on autonomous AI agents, but rather on the enhanced creativity and efficiency AI lends to human attackers. Focusing on building resilient, multi-layered security systems that can adapt to diverse attack vectors is crucial in this evolving threat environment.”

Nguồn: https://www.techopedia.com/ai-forces-a-cyber-rethink